Теория вероятностей и математическая статистика

Министерство

высшего и среднего специального образования Республики Узбекистан

Ташкенсткий

автомобильно-дорожный институт

Кафедра

"Высшая математика"

Тексты лекций

Теория

вероятностей и математическая статистика

М.У. Гафуров,

Р.Х. Кенджаев,

Ф.М. Закиров

Ташкент 2007

М.У. Гафуров, Р.Х. Кенджаев, Ф.М. Закиров

Теория вероятностей и математическая статистика. 2007 г. -124 стр.

В основу текстов лекций положен семестровый курс теории вероятностей и

математической статистики, читаемый авторами в течение ряда лет в Ташкенстком

автомобильно-дорожном институте. В сборнике основные понятия и факты теории

вероятностей и математической статистики первоначально вводятся для конечных

схем. Далее утверждения и формулы легко переводятся на общий случай. Приведенные

теоретические материалы проиллюстрированы большим числом примеров прикладного

содержания. вероятность выборка числовой корреляционный

В сборнике лекций содержатся следующие разделы: пространство случайных

событий, случайные величины и их числовые характеристики, предельные теоремы,

элементы выборочного пространства, точечное и интервальное статистическое

оценивание, элементы корреляционного и регрессионного анализа, а также проверка

статистических гипотез.

Настоящий сборник рассчитан для студентов экономических специальностей

высших экономических и технических учебных заведений, а также для всех

заинтересованных в освоении вероятностных методов решения практических задач.

Рецензенты: А.А. Абдушукуров - заведующий кафедрой "Теория вероятностей и математическая

статистика" Национального Университета Узбекистана, доктор

физико-математических наук,

Х. Валиджанов - доцент кафедры "Высшая математика" Ташкенсткого автомобильно-дорожного

института, кандидат физико-математических наук

Утверждено на заседании Научно-методического совета естественных и

инженерных наук ТАДИ (протокол №7 от 21 февраля 2007 года).

Оглавление

1. Предмет

теории вероятностей и ее значение для решения экономических, технических задач.

Вероятность и ее определение

. Операции

над событиями. Условная вероятность

. Теоремы

сложения и умножения вероятностей. Формулы полной вероятности и Байеса

.

Последовательность независимых испытаний. Локальная и интегральная теоремы

Лапласа

. Дискретные

случайные величины. Закон распределения. Виды дискретных распределений

. Числовые

характеристики дискретных случайных величин и их свойства

. Функции

распределения и плотности непрерывных случайных величин, их свойства

. Числовые

характеристики непрерывных случайных величин. Виды непрерывных распределений

. Закон

больших чисел и его практическое значение. Понятие о центральной предельной

теореме

. Предмет и

основные задачи математической статистики. Выборка

.

Статистическое распределение выборки. Эмпирическая функция распределения.

Полигон и гистограмма

.

Статистическая оценка. Требования, предъявляемые к статистической оценке.

Выборочное среднее и выборочная дисперсия

.

Интервальные оценки. Доверительный интервал. Доверительные интервалы для

неизвестных параметров нормального распределения

. Элементы корреляционного

и регрессионного анализа

. Выборочный

коэффициент корреляции и его свойства

.

Статистические гипотезы и их классификация. Статистический критерий

. Критерии

согласия

Список

литературы

1. Предмет теории вероятностей и ее значение для решения экономических,

технических задач. Вероятность и ее определение

На протяжении длительного времени человечество изучало и использовало для

своей деятельности лишь так называемые детерминистические закономерности.

Однако, поскольку случайные события врываются в нашу жизнь помимо нашего

желания и постоянно окружают нас, и более того, поскольку почти все явления

природы имеют случайный характер, необходимо научиться их изучать и разработать

для этой цели методы изучения.

По форме проявления причинных связей законы природы и общества делятся на

два класса: детерминированные (предопределенные) и статистические.

Например, на основании законов небесной механики по известному в

настоящем положению планет Солнечной системы может быть практически однозначно

предсказано их положение в любой наперед заданный момент времени, в том числе

очень точно могут быть предсказаны солнечные и лунные затмения. Это пример

детерминированных законов.

Вместе с тем не все явления поддаются точному предсказанию. Так,

долговременные изменения климата, кратковременные изменения погоды не являются

объектами для успешного прогнозирования, т.е. многие законы и закономерности

гораздо менее вписываются в детерминированные рамки. Такого рода законы

называются статистическими. Согласно этим законам, будущее состояние системы

определяется не однозначно, а лишь с некоторой вероятностью.

Теория вероятностей, как и другие математические науки, возродилась и

развилась из потребностей практики. Она занимается изучением закономерностей,

присущих массовым случайным событиям.

Теория вероятностей изучает свойства массовых случайных событий,

способных многократно повторяться при воспроизведении определенного комплекса

условий. Основное свойство любого случайного события, независимо от его

природы, - мера, или вероятность его осуществления.

Наблюдаемые нами события (явления) можно подразделить на три вида:

достоверные, невозможные и случайные.

Достоверным называют событие, которое обязательно произойдет. Невозможным

называют событие, которое заведомо не произойдет. Случайным называют событие,

которое может либо произойти, либо не произойти.

Теория вероятностей не ставит перед собой задачу предсказать, произойдет

единичное событие или нет, так как невозможно учесть влияние на случайное

событие всех причин. С другой стороны, оказывается, что достаточно большое

число однородных случайных событий, независимо от их конкретной природы,

подчиняется определенным закономерностям, а именно - вероятностным

закономерностям.

Итак, предметом теории вероятностей является изучение вероятностных

закономерностей массовых однородных случайных событий.

Некоторые задачи, относящиеся к массовым случайным явлениям, пытались

решать, используя соответствующий математический аппарат, еще в начале ХVII в.

Изучая ход и результаты различных азартных игр, Б. Паскаль, П. Ферма и Х.

Гюйгенс в середине XVII века заложили основы классической теории вероятностей.

В своих работах они неявно использовали понятия вероятности и математического

ожидания случайной величины. Только в начале XVIII в. Я. Бернулли формулирует

понятие вероятности.

Дальнейшими успехами теория вероятностей обязана Муавру, Лапласу, Гауссу,

Пуассону и др.

В развитие теории вероятностей огромный вклад внесли русские и советские

математики, такие как П.Л. Чебышев, А.А. Марков, А.М. Ляпунов, С.Н. Бернштейн,

А.Н. Колмогоров, А.Я. Хинчин, А. Прохоров и др.

Особое место в развитии теории вероятностей принадлежит и узбекистанской

школе, яркими представителями которой являются академики В.И. Романовский, С.Х.

Сираждинов, Т.А. Сарымсаков, Т.А. Азларов, Ш.К. Фарманов, профессора И.С.

Бадалбаев, М.У. Гафуров, Ш.А. Хашимов и др.

Как уже было отмечено, потребности практики, способствовав зарождению

теории вероятностей, питали ее развитие как науки, приводя к появлению все

новых ее ветвей и разделов. На теорию вероятностей опирается математическая

статистика, задача которой состоит в том, чтобы по выборке восстановить с

определенной степенью достоверности характеристики, присущие генеральной

совокупности. От теории вероятностей отделились такие отрасли науки, как теория

случайных процессов, теория массового обслуживания, теория информации, теория

надежности, эконометрическое моделирование и др.

В качестве важнейших сфер приложения теории вероятностей можно указать

экономические, технические науки. В настоящее время трудно себе представить

исследование экономико-технических явлений без моделирований, опирающихся на

теорию вероятностей, без моделей корреляционного и регрессионного анализа,

адекватности и "чувствительных" адаптивных моделей.

События, происходящие в автомобильных потоках, степень надежности

составных частей машин, автокатастрофы на дорогах, различные ситуации в

процессе проектирования дорог ввиду их недетерминированности входят в круг

проблем, исследуемых посредством методов теории вероятностей.

Основные понятия теории вероятностей - это опыт или эксперимент и

события. Действия, которые осуществляются при определенных условиях и

обстоятельствах, мы назовем экспериментом. Каждое конкретное осуществление

эксперимента называется испытанием.

Всякий

мыслимый результат эксперимента называется элементарным событием и обозначается

через  . Случайные события состоят из некоторого числа

элементарных событий и обозначаются через A, B, C, D,...

. Случайные события состоят из некоторого числа

элементарных событий и обозначаются через A, B, C, D,...

Множество

элементарных событий таких, что

)

в результате проведения эксперимента всегда происходит одно из

элементарных событий  ;

;

)

при одном испытании произойдет только одно элементарное событие  называется пространством элементарных событий и

обозначается через

называется пространством элементарных событий и

обозначается через  .

.

Таким

образом, любое случайное событие является подмножеством пространства

элементарных событий. По определению пространства элементарных событий

достоверное событие можно обозначить через  .

Невозможное событие обозначается через

.

Невозможное событие обозначается через  .

.

Пример 1. Бросается игральная кость. Пространство элементарных событий,

отвечающее данному эксперименту, имеет следующий вид:

.

.

Пример

2. Пусть в урне содержатся 2 красных, 3 синих и 1 белый, всего 6 шаров.

Эксперимент состоит в том, что из урны вынимаются наудачу шары. Пространство

элементарных событий, отвечающее данному эксперименту, имеет следующий вид:

,

,

где

элементарные события имеют следующие значения:  -

появился белый шар;

-

появился белый шар;  - появился красный шар;

- появился красный шар;  - появился синий шар. Рассмотрим следующие события:

- появился синий шар. Рассмотрим следующие события:

А

- появление белого шара;

В

- появление красного шара;

С

- появление синего шара;- появление цветного (небелого) шара.

Здесь мы

видим, что каждое из этих событий обладает той или иной степенью возможности:

одни - большей, другие - меньшей. Очевидно, что степень возможности события В

больше, чем события А; события С - чем события В; события D - чем события С.

Чтобы количественно сравнивать между собой события по степени их возможности,

очевидно, нужно с каждым событием связать определенное число, которое тем

больше, чем более возможно событие.

Это

число обозначим через  и назовем вероятностью события А. Дадим теперь

определение вероятности.

и назовем вероятностью события А. Дадим теперь

определение вероятности.

Пусть

пространство элементарных событий  является

конечным множеством и элементы его суть

является

конечным множеством и элементы его суть  . Будем

считать, что они являются равновозможными элементарными событиями, т.е. каждое

элементарное событие не имеет больше шансов появления, чем другие. Как

известно, каждое случайное событие А состоит из элементарных событий как

подмножество

. Будем

считать, что они являются равновозможными элементарными событиями, т.е. каждое

элементарное событие не имеет больше шансов появления, чем другие. Как

известно, каждое случайное событие А состоит из элементарных событий как

подмножество  . Эти элементарные события называются

благоприятствующими для А.

. Эти элементарные события называются

благоприятствующими для А.

Вероятность

события А определяется формулой

, (1.1)

, (1.1)

где

m - число благоприятствующих элементарных событий для А, n - число всех

элементарных событий, входящих в  .

.

Если в примере 1 через А обозначить событие, состоящее в том, что выпадет

четное число очков, то

.

.

В

примере 2 вероятности событий имеют следующие значения:

;

;  ;

;  ;

;  .

.

Из определения вероятности вытекают следующие ее свойства:

. Вероятность достоверного события равна единице.

Действительно, если событие достоверно, то все элементарные события

благоприятствуют ему. В этом случае m=n и, следовательно,

.

.

.

Вероятность невозможного события равна нулю.

Действительно,

если событие невозможно, то ни одно элементарное событие не благоприятствует

ему. В этом случае m=0 и, следовательно,

.

.

.

Вероятность случайного события есть положительное число, заключенное между

нулем и единицей.

Действительно,

случайному событию благоприятствует лишь часть из общего числа элементарных

событий. В этом случае  , а значит,

, а значит,  и,

следовательно,

и,

следовательно,

.

.

Итак,

вероятность любого события удовлетворяет неравенствам

. (1.2)

. (1.2)

Относительной

частотой события называют отношение числа испытаний, в которых событие

появилось, к общему числу фактически произведенных испытаний.

Таким

образом, относительная частота события А определяется формулой

, (1.3)

, (1.3)

где

т - число появлений события, п - общее число испытаний.

Сопоставляя

определения вероятности и относительной частоты, заключаем: определение

вероятности не требует, чтобы испытания производились в действительности;

определение же относительной частоты предполагает, что испытания были

произведены фактически.

Пример

3. Из 80 случайно отобранных одинаковых деталей выявлено 3 бракованных.

Относительная частота бракованных деталей равна

.

.

Пример

4. В течение года на одном из объектов было проведено 24 проверки, причем было

зарегистрировано 19 нарушений законодательства. Относительная частота нарушений

законодательства равна

.

.

Длительные

наблюдения показали, что если в одинаковых условиях производятся опыты, в

каждом из которых число испытаний достаточно велико, то относительная частота

изменяется мало (тем меньше, чем больше произведено испытаний), колеблясь около

некоторого постоянного числа. Оказалось, что это постоянное число есть

вероятность появления события.

Таким

образом, если опытным путем установлена относительная частота, то полученное

число можно принять за приближенное значение вероятности. Это есть

статистическое определение вероятности.

В

заключении рассмотрим геометрическое определение вероятности.

Если

пространство элементарных событий  рассматривать

как некоторую область на плоскости или в пространстве, а А как ее подмножество,

то вероятность события А будет рассматриваться как отношение площадей или

объемов А и

рассматривать

как некоторую область на плоскости или в пространстве, а А как ее подмножество,

то вероятность события А будет рассматриваться как отношение площадей или

объемов А и  , и находиться по следующим формулам:

, и находиться по следующим формулам:

, (1.4)

, (1.4)

. (1.5)

. (1.5)

Вопросы для повторения и контроля:

1. На какие классы делятся законы природы и общества по форме

проявления причинных связей?

2. На какие виды можно подразделить события?

. Что является предметом теории вероятностей?

. Что вы знаете об истории развития теории вероятностей?

. Каково значение теории вероятностей для экономических,

технических задач?

. Что такое эксперимент, испытание, элементарное событие и

событие, как они обозначаются?

. Что называется пространством элементарных событий?

. Как определяется вероятность события?

. Какие свойства вероятности вы знаете?

10. Что вы знаете об относительной частоте события?

11. В чем сущность статистического определения вероятности?

12. Каково геометрическое определение вероятности?

. Операции над событиями. Условная вероятность

Часто возникает вопрос: насколько связаны два случайных события А и В

друг с другом, в какой мере наступление одного из них влияет на возможность

наступления другого?

В качестве примера связи между двумя событиями можно привести случаи,

когда наступление одного из событий ведет к обязательному осуществлению другого

или же, наоборот, когда наступление одного события исключает шансы другого.

Если в результате эксперимента события А и В не могут наступить

одновременно, то они называются несовместными событиями, в противном случае

совместными.

Пример 1. Из ящика с деталями наудачу извлечена деталь. То, что она

стандартна, исключает ее нестандартность. События "Наудачу извлеченная

деталь стандартна" и "Наудачу извлеченная деталь нестандартна" -

несовместные.

Если события рассматривать как подмножества пространства элементарных

событий, то отношения между событиями можно интерпретировать как соотношения

между множествами. Несовместные события - это такие события, которые не

содержат общих элементарных событий.

Говорят,

что событие А влечет за собой событие В, если в результате эксперимента из

наступления события А обязательно следует наступление события В, и обозначают это

через  . Если

. Если  и

и  , то

, то  .

.

Пример

2. Бросается игральная кость. Событие "выпало 4" влечет за собой

событие "выпало четное число очков".

Суммой

двух событий А и В называют событие, состоящее в наступлении события А или

события В, или обоих этих событий. Оно обозначается через А+В или  . Суммой нескольких событий называют событие, которое

состоит в наступлении хотя бы одного из этих событий.

. Суммой нескольких событий называют событие, которое

состоит в наступлении хотя бы одного из этих событий.

Пример

3. Из орудия производится два выстрела. Если А - попадание при первом выстреле,

а В - попадание при втором выстреле, то А+В - попадание при первом выстреле,

или при втором, или в обоих выстрелах.

Произведением

двух событий А и В называют событие, состоящее в совместном наступлении событий

А и В. Оно обозначается через АВ или  .

Произведением нескольких событий называют событие, состоящее в совместном

наступлении всех этих событий.

.

Произведением нескольких событий называют событие, состоящее в совместном

наступлении всех этих событий.

Пример

4. В ящике содержатся детали, изготовленные заводами №1 и №2. Если А -

появление стандартной детали, а В - деталь изготовлена заводом №1, то АВ -

появление стандартной детали завода №1.

Противоположное

событие для события А обозначается через  . Оно

считается наступившим тогда и только тогда, когда А не наступает. Иными

словами, А и

. Оно

считается наступившим тогда и только тогда, когда А не наступает. Иными

словами, А и  - это такие несовместные события, которые вместе

образуют достоверное событие, т.е.

- это такие несовместные события, которые вместе

образуют достоверное событие, т.е.

.

.

Пример

5. Попадание и промах при выстреле по цели - противоположные события. Если А -

попадание, то  - промах.

- промах.

Событие,

которое представляет собой наступление события А и не наступление события В,

называется разностью событий А и В, и обозначается через A\В.

Два

события называют независимыми, если вероятность одного из них не зависит от

наступления или ненаступления другого. В противном случае эти события

называются зависимыми.

Пример

6. Монета брошена 2 раза. Вероятность появления герба при первом бросании

(событие А) не зависит от появления герба при втором бросании (событие В). В

свою очередь, вероятность выпадения герба при втором бросании не зависит от

результата первого бросания. Таким образом, события А и В - независимы.

Несколько

событий называют попарно независимыми, если любые два из них взаимно

независимы.

Пусть

А и В - два случайных события, причем  . Из

определения зависимых событий следует, что вероятность одного из событий

зависит от наступления или ненаступления другого. Поэтому, если нас интересует

вероятность события А, то важно знать, наступило ли событие В.

. Из

определения зависимых событий следует, что вероятность одного из событий

зависит от наступления или ненаступления другого. Поэтому, если нас интересует

вероятность события А, то важно знать, наступило ли событие В.

Вероятность

события А при условии, что произошло событие В, называется условной

вероятностью и обозначается через  .

.

Пример

7. В урне содержится 3 белых и 3 черных шара. Из урны дважды вынимают наудачу

по одному шару, не возвращая их в урну. Найти вероятность появления белого шара

при втором испытании (событие А), если при первом испытании был извлечен черный

шар (событие В).

Решение.

После первого испытания в урне осталось всего 5 шаров, из них 3 белых. Искомая

условная вероятность равна

.

.

Выведем

теперь формулу условной вероятности. Пусть событиям А и В благоприятствуют

соответственно m и k элементарных событий из n; тогда, согласно (1.1), их

безусловные вероятности равны  и

и  соответственно. Пусть событию А при условии, что

событие В произошло, благоприятствуют r элементарных событий, тогда, согласно

(1.1), условная вероятность события А равна

соответственно. Пусть событию А при условии, что

событие В произошло, благоприятствуют r элементарных событий, тогда, согласно

(1.1), условная вероятность события А равна

.

.

Разделив

и числитель, и знаменатель на n, получим формулу условной вероятности

Или

. (2.1)

. (2.1)

поскольку

событию АВ соответствуют r элементарных событий и, следовательно,  - его безусловная вероятность.

- его безусловная вероятность.

Вопросы для повторения и контроля:

1. Какие события называются несовместными, а какие совместными?

2. Что означает выражение "событие А влечет за собой событие

В" и как оно обозначается?

. Что называется суммой событий и как оно обозначается?

. Что называется произведением событий и как оно обозначается?

. Что такое противоположное событие и как оно обозначается?

. Что называется разностью событий и как оно обозначается?

. Какие события называются независимыми, а какие зависимыми?

. Что такое условная вероятность и какова ее формула?

. Теоремы сложения и умножения вероятностей. Формулы полной вероятности и

Байеса

Пусть события А и В - несовместные, причем вероятности этих событий даны.

Как найти вероятность того, что наступит либо событие А, либо событие В, т.е.

вероятность суммы этих событий А+В? Ответ на этот вопрос дает следующая

теорема.

Теорема 3.1 (сложения вероятностей несовместных событий). Вероятность

суммы двух несовместных событий равна сумме вероятностей этих событий:

. (3.1)

. (3.1)

Доказательство.

Введем обозначения:

- общее

число элементарных событий;

- общее

число элементарных событий;

- число

элементарных событий, благоприятствующих событию А;

- число

элементарных событий, благоприятствующих событию А;

- число

элементарных событий, благоприятствующих событию В.

- число

элементарных событий, благоприятствующих событию В.

Число

элементарных событий, благоприятствующих наступлению либо события А, либо

события В, равно  . Следовательно,

. Следовательно,

.

.

Приняв

во внимание, что  и

и  ,

окончательно получим

,

окончательно получим

.

.

Следствие

3.1. Вероятность суммы нескольких несовместных событий равна сумме вероятностей

этих событий:

. (3.2)

. (3.2)

Пример

1. В урне 30 шаров: 10 красных, 5 синих и 15 белых. Найти вероятность появления

цветного шара.

Решение.

Появление цветного шара означает появление либо красного, либо синего шара.

Вероятность

появления красного шара (событие А)

.

.

Вероятность

появления синего шара (событие В)

.

.

События

А и В несовместны (появление шара одного цвета исключает появление шара другого

цвета), поэтому искомая вероятность равна

.

.

Так

как противоположные события вместе образуют достоверное событие, то из теоремы

3.1 вытекает, что

,

,

поэтому

. (3.3)

. (3.3)

Пример

2. Вероятность того, что день будет дождливым, равна  . Найти вероятность того, что день будет ясным.

. Найти вероятность того, что день будет ясным.

Решение.

События "день дождливый" и "день ясный" - противоположные,

поэтому искомая вероятность равна

.

.

Из

формулы (2.1) получаем следующую теорему.

Теорема

3.2 (умножения вероятностей зависимых событий). Вероятность произведения двух

зависимых событий равна произведению вероятности одного из них на условную

вероятность другого, вычисленную в предположении, что первое событие уже

наступило:

. (3.4)

. (3.4)

Пример

3. У сборщика имеется 3 конусных и 7 эллиптических валиков. Сборщик наудачу

взял один валик, а затем второй. Найти вероятность того, что первый из взятых

валиков - конусный, а второй - эллиптический.

Решение.

Вероятность

того, что первый из взятых валиков окажется конусным (событие В), равна

.

.

Условная

вероятность того, что второй из валиков окажется эллиптическим (событие А),

вычисленная в предположении, что первый валик - конусный, равна

.

.

Тогда

по формуле (3.4) искомая вероятность равна

.

.

Теперь

перейдем к случаю, когда события А и В - независимые, и найдем вероятность

произведения этих событий.

Так

как событие А не зависит от события В, то его условная вероятность  равна его безусловной вероятности

равна его безусловной вероятности  , т.е.

, т.е.

.

.

Отсюда

вытекает следующая теорема.

Теорема

3.3 (умножения вероятностей независимых событий). Вероятность произведения двух

независимых событий равна произведению вероятностей этих событий:

. (3.5)

. (3.5)

Следствие

3.2. Вероятность произведения нескольких независимых событий равна произведению

вероятностей этих событий:

.

.

Пример

4. Имеется 3 ящика, содержащих по 10 деталей. В первом ящике 8, во втором 7 и в

третьем 9 стандартных деталей. Из каждого ящика наудачу вынимают по одной

детали. Найти вероятность того, что все три вынутые детали окажутся

стандартными.

Решение.

Вероятность того, что из первого ящика вынута стандартная деталь (событие А),

равна

.

.

Вероятность

того, что из второго ящика вынута стандартная деталь (событие В), равна

.

.

Вероятность

того, что из третьего ящика вынута стандартная деталь (событие С), равна

.

.

Так

как события А, В и С - независимые, то искомая вероятность по теореме умножения

вероятностей независимых событий равна

.

.

Теперь

перейдем к случаю, когда события А и В - совместные, и найдем вероятность суммы

этих событий.

Теорема

3.4 (сложения вероятностей совместных событий). Вероятность суммы двух

совместных событий равна сумме вероятностей этих событий с вычетом вероятности

их произведения:

. (3.6)

. (3.6)

Пример

5. Вероятности попадания в цель при стрельбе первого и второго орудий

соответственно равны:  ;

;  . Найти

вероятность попадания при одном залпе (из обоих орудий) хотя бы одним из

орудий.

. Найти

вероятность попадания при одном залпе (из обоих орудий) хотя бы одним из

орудий.

Решение.

Вероятность попадания в цель каждым из орудий не зависит от результата стрельбы

из другого орудия, поэтому события А (попадание первого орудия) и В (попадание

второго орудия) независимы.

Вероятность

события АВ (оба орудия дали попадание), равна

.

.

Искомая

вероятность равна

.

.

Если

независимые события  вместе образуют достоверное событие, то вероятность

появления хотя бы одного из этих событий можно найти по формуле

вместе образуют достоверное событие, то вероятность

появления хотя бы одного из этих событий можно найти по формуле

(3.7)

(3.7)

Пример

6. В типографии имеются 4 машины. Для каждой машины вероятность того, что она

работает в данный момент, равна 0,9. Найти вероятность того, что в данный

момент работает хотя бы одна машина (событие А).

Решение.

Вероятность того, что машина в данный момент не работает, равна

.

.

Тогда

искомая вероятность равна

.

.

Говорят,

что события  образуют полную группу событий, если они несовместны

и вместе образуют достоверное событие, т.е.

образуют полную группу событий, если они несовместны

и вместе образуют достоверное событие, т.е.  ,

,  ;

;  .

.

Предположим,

что событие А может наступить только при условии появления одного из событий  , образующих полную группу, которые назовем

гипотезами. Пусть известны вероятности этих событий и условные вероятности

, образующих полную группу, которые назовем

гипотезами. Пусть известны вероятности этих событий и условные вероятности  ,

,  .

.

Так

как  , то

, то

.

.

Из

несовместности  вытекает несовместность событий

вытекает несовместность событий  .

.

Применяя

формулу (3.1), имеем

.

.

Согласно

формуле (3.4) (так как события  могут

быть и зависимыми), заменив каждое слагаемое

могут

быть и зависимыми), заменив каждое слагаемое  в правой

части последнего выражения произведением

в правой

части последнего выражения произведением  , получим

формулу полной вероятности

, получим

формулу полной вероятности

. (3.8)

. (3.8)

Пример

7. Имеется два набора деталей. Вероятность того, что деталь первого набора

стандартна, равна 0,8, а второго - 0,9. Найти вероятность того, что взятая

наудачу деталь из наудачу взятого набора - стандартная.

Решение.

Обозначим через А событие "извлеченная деталь стандартна". Деталь

может быть извлечена либо из первого набора (событие  ), либо из второго набора (событие

), либо из второго набора (событие  ).

).

Вероятность

того, что деталь будет вынута из первого набора, равна

.

.

Вероятность

того, что деталь будет вынута из второго набора, равна

.

.

По

условиям задачи  и

и  .

.

Тогда

искомая вероятность находится по формуле полной вероятности и равна

.

.

Пусть

теперь для тех же событий, что и при выводе формулы полной вероятности,

появилось событие А, и ставится задача отыскать условные вероятности гипотез  ,

,  .

.

Из

формулы (2.1) имеем

.

.

Далее,

из формулы (3.4) получаем

.

.

Отсюда

и из предыдущего соотношения, применяя формулу полной вероятности, выводим

формулу Байеса:

(3.9)

(3.9)

Пример

8. Детали, изготовляемые цехом завода, попадают для проверки их на

стандартность к одному из двух контролеров. Вероятность того, что деталь

попадет к первому контролеру, равна 0,6, а ко второму - 0,4. Вероятность того,

что годная деталь будет признана стандартной первым контролером, равна 0,94, а

вторым - 0,98. Годная деталь при проверке была признана стандартной. Найти

вероятность того, что эту деталь проверил первый контролер.

Решение.

Обозначим через А событие, состоящее в том, что годная деталь признана

стандартной. Можно сделать два предположения:

) деталь

проверил первый контролер (гипотеза  );

);

) деталь

проверил второй контролер (гипотеза  ).

).

По условиям задачи имеем:

(вероятность

того, что деталь попадет к первому контролеру);

(вероятность

того, что деталь попадет к первому контролеру);

(вероятность

того, что деталь попадет ко второму контролеру);

(вероятность

того, что деталь попадет ко второму контролеру);

(вероятность

того, что годная деталь будет признана стандартной первым контролером);

(вероятность

того, что годная деталь будет признана стандартной первым контролером);

(вероятность

того, что годная деталь будет признана стандартной вторым контролером).

(вероятность

того, что годная деталь будет признана стандартной вторым контролером).

Искомую

вероятность найдем по формуле Байеса

.

.

Вопросы для повторения и контроля:

1. О чем теорема сложения вероятностей несовместных событий и

каково ее доказательство?

2. Чему равна вероятность противоположного события?

. О чем идет речь в теоремах умножения вероятностей зависимых и

независимых событий?

. О чем теорема сложения вероятностей совместных событий?

. Как можно найти вероятность появления хотя бы одного события?

. Какие события образуют полную группу событий?

. Что такое формула полной вероятности и как она выводится?

. Что такое формула Байеса и как она выводится?

Опорные слова:

Вероятность суммы несовместных событий, вероятность противоположного

события, вероятность произведения зависимых событий, вероятность произведения

независимых событий, вероятность суммы несовместных событий, вероятность появления хотя бы одного

события, полная группа событий, гипотезы, формула полной вероятности, формула

Байеса.

. Последовательность независимых испытаний. Локальная и интегральная

теоремы Лапласа

Пусть производится n независимых испытаний, в каждом из которых событие А

может либо произойти (успех), либо не произойти (неудача). Будем считать, что

вероятность события А в каждом испытании одна и та же, а именно равна р.

Следовательно, вероятность ненаступления события А в каждом испытании

также постоянна и равна q=1-p. Такая последовательность испытаний называется

схемой Бернулли.

В качестве таких испытаний можно рассматривать, например, производство

изделий на определенном оборудовании при постоянстве технологических и

организационных условий, в этом случае изготовление годного изделия - успех,

бракованного - неудача.

Эта ситуация соответствует схеме Бернулли, если считать, что процесс

изготовления одного изделия не зависит от того, были годными или бракованными

предыдущие изделия.

Другим примером является стрельба по мишени.

Здесь попадание - успех, промах - неудача.

Поставим своей задачей вычислить вероятность того, что при n испытаниях

событие А осуществится ровно k раз и, следовательно, не осуществится n-k раз,

т.е. будет k успехов и n-k неудач.

Искомую

вероятность обозначим  . Например, символ

. Например, символ  означает

вероятность того, что в пяти испытаниях событие появится ровно 3 раза и,

следовательно, не наступит 2 раза.

означает

вероятность того, что в пяти испытаниях событие появится ровно 3 раза и,

следовательно, не наступит 2 раза.

Последовательность

п независимых испытаний можно рассматривать как сложное событие, являющееся

произведением п независимых событий. Следовательно, вероятность того, что в п

испытаниях событие А наступит k раз и не наступит n-k раз, по теореме 3.3

умножения вероятностей независимых событий, равна

.

.

Таких

сложных событий может быть столько, сколько можно составить сочетаний из п

элементов по k элементов, т.е.  .

.

Так как эти сложные события несовместны, то по теореме 3.1 сложения

вероятностей несовместных событий, искомая вероятность равна сумме вероятностей

всех возможных сложных событий.

Поскольку же вероятности всех этих сложных событий одинаковы, то искомая

вероятность (появление k раз события А в п испытаниях) равна вероятности одного

сложного события, умноженной на их число

Или

(4.1)

(4.1)

Полученную

формулу называют формулой Бернулли.

Пример

1. Вероятность того, что расход электроэнергии на продолжении одних суток не

превысит установленной нормы, равна  . Найти

вероятность того, что в течение 4 суток из ближайших 6 суток расход

электроэнергии не превысит нормы.

. Найти

вероятность того, что в течение 4 суток из ближайших 6 суток расход

электроэнергии не превысит нормы.

Решение.

Вероятность нормального расхода электроэнергии на продолжении каждых из 6 суток

постоянна и равна  . Следовательно, вероятность перерасхода

электроэнергии в каждые сутки также постоянна и равна

. Следовательно, вероятность перерасхода

электроэнергии в каждые сутки также постоянна и равна

.

.

Искомая

вероятность по формуле Бернулли равна

.

.

В

ряде задач представляет интерес наивероятнейшее число успехов, т.е. такое число

успехов, вероятность которого самая большая среди

вероятностей (4.1). Так как при увеличении k вероятности (4.1) сначала

возрастают, а затем, с определенного момента, начинают убывать, то для

успехов, вероятность которого самая большая среди

вероятностей (4.1). Так как при увеличении k вероятности (4.1) сначала

возрастают, а затем, с определенного момента, начинают убывать, то для  должны иметь место соотношения

должны иметь место соотношения

(4.2)

(4.2)

И

. (4.3)

. (4.3)

Используя

формулу (4.1) и соотношение  , из

(4.2) и (4.3) получаем соответственно неравенства

, из

(4.2) и (4.3) получаем соответственно неравенства

(4.4)

(4.4)

И

. (4.5)

. (4.5)

Окончательно

получаем, что  лежит в интервале единичной длины:

лежит в интервале единичной длины:

. (4.6)

. (4.6)

Однако,

стоит заметить, что использование формулы Бернулли при больших значениях п

достаточно трудно, так как формула требует выполнения действий над громадными

числами.

Например,

если  ,

,  ,

,  , то для отыскания вероятности

, то для отыскания вероятности  надо вычислить выражение

надо вычислить выражение

, где

, где  ,

,  ,

,  .

.

Естественно

возникает вопрос: нельзя ли вычислить интересующую нас вероятность, не прибегая

к формуле Бернулли? Оказывается можно. Локальная теорема Лапласа и дает

асимптотическую формулу, которая позволяет приближенно найти вероятность

появления события ровно k раз в n испытаниях, если число испытаний достаточно

велико.

Локальная

теорема Лапласа. Если вероятность р появления события А в каждом испытании

постоянна и отлична от нуля и единицы, то вероятность  того, что событие А появится в п испытаниях ровно k

раз, приближенно равна (тем точнее, чем больше п) значению функции

того, что событие А появится в п испытаниях ровно k

раз, приближенно равна (тем точнее, чем больше п) значению функции

при

.

.

Имеются

таблицы, в которых помещены значения функции  .

При этом следует учитывать, что

.

При этом следует учитывать, что  , так как

функция

, так как

функция  четна.

четна.

Итак,

вероятность того, что событие А появится в п независимых испытаниях ровно k

раз, приближенно равна

, (4.7)

, (4.7)

где

.

.

Пример

2. Найти вероятность того, что событие А наступит ровно 80 раз в 400

испытаниях, если вероятность появления этого события в каждом испытании равна

0,2.

Решение.

По условию  ;

;  ;

;  ;

;  .

Воспользуемся формулой (4.7):

.

Воспользуемся формулой (4.7):

.

.

Вычислим

определяемое данными задачи значение х:

.

.

По

таблице находим  .

.

Искомая

вероятность равна

.

.

Формула

Бернулли приводит примерно к такому же результату (выкладки, ввиду их

громоздкости, опущены):

.

.

Пусть

теперь требуется вычислить вероятность  того,

что событие А появится в п испытаниях не менее

того,

что событие А появится в п испытаниях не менее  и не

более

и не

более  раз (для краткости будем говорить "от

раз (для краткости будем говорить "от  до

до  раз").

Эта задача решается с помощью следующей теоремы.

раз").

Эта задача решается с помощью следующей теоремы.

Интегральная

теорема Лапласа. Если вероятность р наступления события А в каждом испытании

постоянна и отлична от нуля и единицы, то вероятность  того, что событие А появится в п испытаниях от

того, что событие А появится в п испытаниях от  до

до  раз,

приближенно равна определенному интегралу

раз,

приближенно равна определенному интегралу

, (4.8)

, (4.8)

где

и

и  .

.

При

решении задач, требующих применения интегральной теоремы Лапласа, пользуются

специальной таблицей для интеграла  . В

таблице даны значения функции

. В

таблице даны значения функции  для

для  , а для

, а для  воспользуемся

нечетностью функции

воспользуемся

нечетностью функции  , т.е.

, т.е.  . Функцию

. Функцию

часто называют функцией Лапласа.

часто называют функцией Лапласа.

Итак,

вероятность того, что событие А появится в п независимых испытаниях от  до

до  раз,

равна

раз,

равна

, (4.9)

, (4.9)

где

и

и  .

.

Пример

3. Вероятность того, что организация не прошла проверку налоговой инспекции,

равна  . Найти вероятность того, что среди 400 случайно

отобранных организаций не прошедших проверку окажется от 70 до 100 организаций.

. Найти вероятность того, что среди 400 случайно

отобранных организаций не прошедших проверку окажется от 70 до 100 организаций.

Решение.

По условию  ;

;  ;

;  ;

;  ;

;  . Воспользуемся формулой (4.9):

. Воспользуемся формулой (4.9):

.

.

Вычислим

нижний и верхний пределы интегрирования:

;

;

.

.

Таким

образом, имеем

.

.

По

таблице значений функции  находим

находим

;

;  .

.

.

.

В

теме №1 было отмечено, что по статистическому определению вероятности в

качестве вероятности можно взять относительную частоту, поэтому представляет

интерес оценка разности между ними. Вероятность того, что отклонение

относительной частоты  от постоянной вероятности р по абсолютной величине не

превышает заданного числа

от постоянной вероятности р по абсолютной величине не

превышает заданного числа  , равна

, равна

. (4.10)

. (4.10)

Пример

4. Вероятность того, что деталь не стандартна, равна  . Найти вероятность того, что среди случайно

отобранных 400 деталей относительная частота появления нестандартных деталей

отклонится от вероятности

. Найти вероятность того, что среди случайно

отобранных 400 деталей относительная частота появления нестандартных деталей

отклонится от вероятности  по абсолютной величине не более, чем на 0,03.

по абсолютной величине не более, чем на 0,03.

Решение.

По условию  ;

;  ;

;  ;

;  .

.

Требуется

найти вероятность  .

.

Пользуясь

формулой (4.10), имеем

.

.

По

таблице находим  . Следовательно,

. Следовательно,  .

.

Итак,

искомая вероятность приближенно равна 0,9544.

Смысл

полученного результата таков: если взять достаточно большое число проб по 400

деталей в каждой, то примерно в 95,44% этих проб отклонение относительной

частоты от постоянной вероятности  по

абсолютной величине не превысит 0,03.

по

абсолютной величине не превысит 0,03.

Вопросы для повторения и контроля:

1. Что называется схемой Бернулли?

2. Как выводится формула Бернулли?

. Как находится наивероятнейшее число успехов?

. О чем идет речь в локальной теореме Лапласа?

. О чем идет речь в интегральной теореме Лапласа?

. Как находится вероятность отклонения относительной частоты от

постоянной вероятности?

Опорные слова:

Последовательность

независимых испытаний, схема Бернулли, формула Бернулли, наивероятнейшее число успехов, локальная теорема

Лапласа, вероятность того, что событие А появится в п независимых испытаниях ровно

k раз, интегральная теорема Лапласа, вероятность того, что событие А появится в

п независимых испытаниях от  до

до  раз, функция Лапласа, вероятность отклонения

относительной частоты от постоянной вероятности.

раз, функция Лапласа, вероятность отклонения

относительной частоты от постоянной вероятности.

.

Дискретные случайные величины. Закон распределения. Виды дискретных

распределений

В предыдущих темах неоднократно приводились события, состоящие в

появлении того или иного числа. Например, при бросании игральной кости могли появиться

числа 1, 2, 3, 4, 5 и 6. Наперед определить число выпавших очков невозможно,

поскольку оно зависит от многих случайных причин, которые полностью не могут

быть учтены. В этом смысле число очков есть величина случайная; числа 1, 2, 3,

4, 5 и 6 есть возможные значения этой величины.

Случайной величиной называют величину, которая в результате испытания

примет одно и только одно возможное значение, наперед не известное и зависящее

от случайных причин, которые заранее не могут быть учтены.

Пример 1. Число родившихся мальчиков среди ста новорожденных есть

случайная величина, которая имеет следующие возможные значения: 0, 1, 2, ... ,

100.

Пример

2. Расстояние, которое пролетит снаряд при выстреле из орудия, есть случайная

величина. Возможные значения этой величины принадлежат некоторому промежутку  .

.

Так

как в результате испытаний происходят элементарные события, то можно связать

понятия случайной величины и элементарных событий и дать другое определение

случайной величины.

Случайной

величиной называется функция  ,

определенная на пространстве элементарных событий

,

определенная на пространстве элементарных событий  ,

,  .

.

Пример

3. При подбрасывании двух монет число выпавших гербов Х есть случайная

величина, которая может принимать значения 0, 1 и 2. Пространство элементарных

событий состоит из следующих элементарных событий:

,

,  ,

,  ,

,  .

.

Тогда

Х принимает следующие значения:

,

,  ,

,

,

,  .

.

Случайные

величины обозначаются прописными латинскими буквами  , а их возможные значения - соответствующими строчными

буквами

, а их возможные значения - соответствующими строчными

буквами  . Например, если случайная величина Х имеет три

возможных значения, то они обозначаются через

. Например, если случайная величина Х имеет три

возможных значения, то они обозначаются через  .

.

Дискретной

(прерывной) называют случайную величину, которая принимает отдельные,

изолированные возможные значения с определенными вероятностями. Число возможных

значений дискретной случайной величины может быть конечным или бесконечным. В

качестве примера таковой можно привести случайную величину из примера 1.

Непрерывной

называют случайную величину, которая может принимать все значения из некоторого

конечного или бесконечного промежутка. Число возможных значений непрерывной

случайной величины бесконечно. В качестве примера такой величиныможно привести

случайную величину из примера 2.

Для

задания дискретной случайной величины недостаточно перечислить все возможные ее

значения, нужно еще указать их вероятности. С другой стороны, во многих задачах

нет необходимости рассматривать случайные величины как функции от элементарного

события, а достаточно знать лишь вероятности возможных значений случайной

величины, т.е. закон распределения случайной величины.

Законом

распределения вероятностей или просто законом распределения дискретной

случайной величины называют соответствие между возможными значениями и их

вероятностями; его можно задать в виде таблицы, графика и формулы.

Рассмотрим различные способы задания закона распределения вероятностей на

примерах.

При табличном задании закона распределения дискретной случайной величины

первая строка таблицы содержит возможные значения, а вторая - их вероятности.

Сумма вероятностей во второй строке таблицы должна быть равна 1. В таблице 5.1

задан закон распределения дискретной случайной величины из примера 3.

Таблица 5.1

|

012 012

|

|

|

|

|

1 / 41 / 21 / 4 1 / 41 / 21 / 4

|

|

|

|

Пример 4. В денежной лотерее выпущено 100 билетов. Разыгрывается один

выигрыш в 5000 сум, пять выигрышей по 1000 сум и десять выигрышей по 500 сум.

Найти закон распределения случайной величины Х - стоимости возможного выигрыша

для владельца одного лотерейного билета.

Решение.

Напишем возможные значения Х:  ,

,  ,

,  ,

,  . Вероятности этих возможных значений таковы:

. Вероятности этих возможных значений таковы:  ,

,  ,

,  ,

,  .

.

Тогда

искомый закон распределения имеет вид

Таблица 5.2

|

050010005000 050010005000

|

|

|

|

|

|

0,840,10,050,01 0,840,10,050,01

|

|

|

|

|

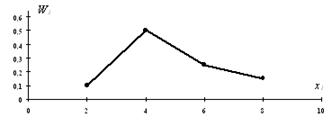

Для

наглядности закон распределения дискретной случайной величины можно изобразить

и графически, для чего в прямоугольной системе координат строят точки  , а затем соединяют их отрезками прямых. Полученную

фигуру называют многоугольником распределения. На рисунке 5.1 приведен

многоугольник распределения случайной величины Х из примера 3.

, а затем соединяют их отрезками прямых. Полученную

фигуру называют многоугольником распределения. На рисунке 5.1 приведен

многоугольник распределения случайной величины Х из примера 3.

Теперь

рассмотрим некоторые дискретные распределения, заданные посредством формул:

биномиальное, геометрическое и Пуассона.

Пусть

производится n независимых испытаний, в каждом из которых вероятность

наступления события А (успеха) постоянна и равна p (следовательно, вероятность

непоявления (неудачи) равна q=1-p). Рассмотрим в качестве дискретной случайной

величины Х число появлений события А в этих испытаниях. Возможные значения Х

таковы: 0, 1, 2, ..., n. Вероятности этих возможных значений находятся по

формуле Бернулли (4.1):

,

,

где

k= 0, 1, 2, ..., n.

Рис.

5.1.

Биномиальным

называют распределение вероятностей, определяемое формулой Бернулли. Закон

назван "биномиальным" потому, что правую часть формулы Бернулли можно

рассматривать как общий член разложения бинома Ньютона:

.

.

Так

как p + q = 1, то сумма вероятностей возможных значений случайной величины

равна 1.

Таким

образом, биномиальный закон распределения имеет вид

Таблица 5.3

В качестве примера биномиального распределения можно привести

распределение случайной величины из примера 3.

Пусть

производятся независимые испытания, в каждом из которых вероятность появления

события А (успеха) равна р ( ) и,

следовательно, вероятность его непоявления (неудачи) равна q=1-p. Испытания

продолжаются до первого успеха. Таким образом, если событие А появилось в k-м

испытании, то в предшествующих k - 1 испытаниях оно не появлялось.

) и,

следовательно, вероятность его непоявления (неудачи) равна q=1-p. Испытания

продолжаются до первого успеха. Таким образом, если событие А появилось в k-м

испытании, то в предшествующих k - 1 испытаниях оно не появлялось.

Если

через Х обозначить дискретную случайную величину, равную числу испытаний до

первого успеха, то ее возможными значениями будут натуральные числа 1, 2, 3,

...

Пусть

в первых k - 1 испытаниях событие А не наступило, а в k-м испытании появилось.

Вероятность этого "сложного события", по теореме 3.3 умножения

вероятностей независимых событий, равна

. (5.1)

. (5.1)

Геометрическим

называют распределение вероятностей, определяемое формулой (5.1), так как

полагая в этой формуле k = 1, 2, ..., получим геометрическую прогрессию с

первым членом р и знаменателем q ( ):

):

Просуммировав

бесконечно убывающую геометрическую прогрессию, легко убедиться, что сумма

вероятностей возможных значений случайной величины равна 1:

.

.

Таким

образом, геометрический закон распределения имеет вид

Таблица 5.4

Пример

5. Из орудия производится стрельба по цели до первого попадания. Вероятность

попадания в цель  . Найти вероятность того, что попадание произойдет при

третьем выстреле.

. Найти вероятность того, что попадание произойдет при

третьем выстреле.

Решение.

По условию  ,

,  ,

,  . Искомая вероятность по формуле (5.1) равна:

. Искомая вероятность по формуле (5.1) равна:

.

.

Пусть

производится n независимых испытаний, в каждом из которых вероятность появления

события А равна р. Для определения вероятности k появлений события в этих

испытаниях используют формулу Бернулли. Если же п велико, то пользуются

локальной теоремой Лапласа. Однако она дает большую погрешность, если

вероятность события мала ( ).

).

Если

сделать допущение, что произведение  при

при  сохраняет постоянное значение, а именно

сохраняет постоянное значение, а именно  , то вероятность того, что при очень большом числе испытаний,

в каждом из которых вероятность события очень мала, событие наступит ровно k

раз, находится по следующей формуле

, то вероятность того, что при очень большом числе испытаний,

в каждом из которых вероятность события очень мала, событие наступит ровно k

раз, находится по следующей формуле

. (5.2)

. (5.2)

Эта

формула выражает закон распределения Пуассона вероятностей массовых (п велико)

и маловероятных (р мало) событий. Имеются специальные таблицы для распределения

Пуассона.

Пример

6. Завод отправил на базу 5000 доброкачественных изделий. Вероятность того, что

в пути изделие повредится, равно 0,0002. Найти вероятность того, что на базу

прибудут 3 негодных изделия.

Решение.

По условию  ,

,  ,

,  . Найдем

. Найдем  :

:

.

.

Искомая

вероятность по формуле (5.2) равна:

.

.

Вопросы для повторения и контроля:

1. Как определяется случайная величина в общем случае и на языке

функций?

2. Что такое дискретная случайная величина?

. Что такое непрерывная случайная величина?

. Что вы знаете о законе распределения дискретной случайной

величины?

. Что вы знаете о биномиальном законе распределения?

. Каковы особенности геометрического закона распределения?

7. В каких случаях используют распределение Пуассона?

Опорные слова:

Случайная величина, дискретная случайная величина, непрерывная случайная величина, закон

распределения дискретной случайной величины, многоугольник распределения,

биномиальное распределение, геометрическое распределение, распределение

Пуассона.

. Числовые характеристики дискретных случайных величин и их свойства

Как мы видели выше, закон распределения полностью характеризует

дискретную случайную величину. Однако часто закон распределения неизвестен и

приходится ограничиваться числами, которые описывают случайную величину

суммарно; такие числа называют числовыми характеристиками случайной величины.

К числу важных числовых характеристик относится математическое ожидание.

Математическое ожидание приближенно равно среднему значению случайной величины.

Для решения многих задач достаточно знать математическое ожидание. Например,

если известно, что математическое ожидание числа выбиваемых очков у первого

стрелка больше, чем у второго, то первый стрелок в среднем выбивает больше

очков, чем второй, и, следовательно, стреляет лучше второго.

Математическим ожиданием дискретной случайной величины Х называется сумма

произведений всех ее возможных значений на их вероятности и обозначается через

М(Х).

Пусть

случайная величина Х принимает значения  с

соответствующими вероятностями

с

соответствующими вероятностями  . Тогда

математическое ожидание М(Х) случайной величины Х определяется равенством

. Тогда

математическое ожидание М(Х) случайной величины Х определяется равенством

. (6.1)

. (6.1)

Если

дискретная случайная величина Х принимает бесконечное множество возможных

значений, то

. (6.2)

. (6.2)

Пример

1. Найти математическое ожидание случайной величины Х, зная закон ее

распределения

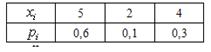

Таблица 6.1

|

352 352

|

|

|

|

|

0,10,60,3 0,10,60,3

|

|

|

|

Решение. Искомое математическое ожидание по формуле (6.1) равно

.

.

Пример

2. Найти математическое ожидание числа появлений события А в одном испытании,

если вероятность события А равна р.

Решение.

Случайная величина Х - число появлений события А в одном испытании - может

принимать только два значения:  (событие

А наступило) с вероятностью р и

(событие

А наступило) с вероятностью р и  (событие

А не наступило) с вероятностью q = 1 - р.

Искомое математическое ожидание по формуле (6.1) равно

(событие

А не наступило) с вероятностью q = 1 - р.

Искомое математическое ожидание по формуле (6.1) равно

.

.

Итак,

математическое ожидание числа появлений события в одном испытании равно

вероятности этого события.

Теперь приведем свойства математического ожидания.

Свойство 6.1. Математическое ожидание постоянной величины равно самой

постоянной:

.

.

Доказательство.

Будем рассматривать постоянную С как дискретную случайную величину, которая

имеет одно возможное значение С и принимает его с вероятностью  . Следовательно,

. Следовательно,

.

.

Свойство

6.2.

Постоянный

множитель можно выносить за знак математического ожидания:

.

.

Две

случайные величины называются независимыми, если закон распределения одной из

них не зависит от того, какие возможные значения приняла другая величина.

Произведением

независимых случайных величин Х и Y называется случайная величина ХY, возможные

значения которой равны произведениям каждого возможного значения Х на каждое

возможное значение Y; вероятности возможных значений произведения ХY равны

произведениям вероятностей возможных значений сомножителей.

Свойство 6.3.

Математическое ожидание произведения двух независимых случайных величин

равно произведению их математических ожиданий:

.

.

Следствие

6.1. Математическое ожидание произведения нескольких независимых случайных

величин равно произведению их математических ожиданий.

Пример

3. Независимые случайные величины Х и Y заданы следующими законами

распределения:

Таблица

6.2

Таблица

6.3

Найти

математическое ожидание случайной величины ХY.

Решение.

Найдем математические ожидания каждой из данных величин:

;

;

.

.

Случайные величины Х и Y независимые, поэтому искомое математическое

ожидание равно

.

.

Суммой

случайных величин Х и Y называется случайная величина Х+Y, возможные значения

которой равны суммам каждого возможного значения Х с каждым возможным значением

Y; вероятности возможных значений Х+Y для независимых величин Х и Y равны

произведениям вероятностей слагаемых; для зависимых величин - произведениям

вероятности одного слагаемого на условную вероятность второго.

Свойство 6.4. Математическое ожидание суммы двух случайных величин равно

сумме математических ожиданий слагаемых:

.

.

Следствие

6.2. Математическое ожидание суммы нескольких случайных величин равно сумме

математических ожиданий слагаемых.

Пример

4. Найти математическое ожидание суммы числа очков, которые могут выпасть при

бросании двух игральных костей.

Решение.

Обозначим число очков, которое может выпасть на первой кости, через Х и на

второй - через Y. Возможные значения этих

величин одинаковы и равны 1, 2, 3, 4, 5 и 6, причем вероятность каждого из этих

значений равна 1/6.

Найдем

математическое ожидание числа очков, которые могут выпасть на первой кости:

.

.

Очевидно,

что и  .

.

Искомое

математическое ожидание равно

.

.

Свойство

6.5. Математическое ожидание числа появлений события А в n независимых

испытаниях, в каждом из которых вероятность р появления события постоянна,

равно произведению числа испытаний на вероятность появления события в одном

испытании:

.

.

Пример

5. Вероятность выявления ошибок в документации при проверке предприятия равна  . Найти математическое ожидание общего числа выявлений

ошибок, если будет проведено 10 проверок предприятий.

. Найти математическое ожидание общего числа выявлений

ошибок, если будет проведено 10 проверок предприятий.

Решение.

Выявление ошибок при каждой проверке не

зависит от исходов других проверок, поэтому рассматриваемые события независимы

и, следовательно, искомое математическое ожидание равно

(выявлений ошибок).

(выявлений ошибок).

Некоторые

случайные величины имеют одинаковые математические ожидания, но различные

возможные значения. Рассмотрим, например, дискретные случайные величины Х и Y, заданные следующими законами распределения:

Таблица

6.4

Таблица

6.5

Найдем

математические ожидания этих величин:

;

;

.

.

Здесь

математические ожидания обеих величин одинаковы, а возможные значения различны,

причем Х имеет возможные значения, близкие к математическому ожиданию, а Y - далекие от своего математического ожидания. Таким

образом, зная лишь математическое ожидание случайной величины, еще нельзя

судить ни о том, какие возможные значения она может принимать, ни о том, как

они рассеяны вокруг математического ожидания.

Другими

словами, математическое ожидание полностью случайную величину не характеризует.

По этой причине наряду с математическим ожиданием рассматриваются и другие

числовые характеристики.

Пусть

Х - случайная величина и М(Х) - ее математическое ожидание. Отклонением

случайной величины называется разность  .

.

На

практике часто требуется оценить рассеяние возможных значений случайной

величины вокруг ее среднего значения. Например, в артиллерии важно знать,

насколько кучно лягут снаряды вблизи цели, которая должна быть поражена.

Дисперсией

(рассеянием) дискретной случайной величины называют математическое ожидание

квадрата отклонения случайной величины от ее математического ожидания:

. (6.3)

. (6.3)

Для

вычисления дисперсии часто бывает удобно воспользоваться следующей формулой:

. (6.4)

. (6.4)

Пример

6. Найти дисперсию случайной величины Х, которая задана следующим законом

распределения:

Таблица 6.6

|

235 235

|

|

|

|

|

0,10,60,3 0,10,60,3

|

|

|

|

Решение. Математическое ожидание М(Х) равно:

.

.

Закон

распределения случайной величины  имеет

вид:

имеет

вид:

Таблица 6.7

|

4925 4925

|

|

|

|

|

0,10,60,3 0,10,60,3

|

|

|

|

Математическое

ожидание  равно:

равно:

.

.

Искомая

дисперсия равна

.

.

Дисперсия,

как и математическое ожидание, имеет несколько свойств.

Свойство

6.6. Дисперсия постоянной величины равна нулю:

.

.

Доказательство.

По определению дисперсии,

.

.

Пользуясь свойством 6.1, получим

.

.

Итак,

.

.

Свойство

становится ясным, если учесть, что постоянная величина сохраняет одно и то же

значение и рассеяния не имеет.

Свойство

6.7. Постоянный множитель можно выносить за знак дисперсии, возводя его в

квадрат:

.

.

Свойство

6.8. Дисперсия суммы двух независимых случайных величин равна сумме дисперсий

этих величин:

.

.

Следствие

6.3. Дисперсия суммы нескольких независимых случайных величин равна сумме

дисперсий этих величин.

Следствие

6.4. Дисперсия суммы постоянной величины и случайной величины равна дисперсии

случайной величины:

.

.

Доказательство.

Величины С и Х независимы, поэтому по свойству 6.8 имеем

.

.

В

силу свойства 6.6  . Следовательно,

. Следовательно,

.

.

Свойство

становится ясным, если учесть, что величины Х и Х + С отличаются лишь началом

отсчета и, значит, рассеяны вокруг своих математических ожиданий одинаково.

Свойство

6.9. Дисперсия разности двух независимых случайных величин равна сумме их

дисперсий:

.

.

Доказательство.

В силу свойства 6.8 имеем

.

.

По свойству 6.7,

.

.

или

.

.

Свойство

6.10. Дисперсия числа появлений события А в n независимых испытаниях, в каждом

из которых вероятность р появления события постоянна, равна произведению числа

испытаний на вероятности появления и непоявления события в одном испытании:

.

.

Пример

7. ГНИ проводит 10 независимых проверок предприятий, в каждой из которых

вероятность выявления ошибок в документации равна  . Найти дисперсию случайной величины Х - числа выявлений

ошибок в документации в этих проверках.

. Найти дисперсию случайной величины Х - числа выявлений

ошибок в документации в этих проверках.

Решение.

По условию,  ,

,  .

Вероятность невыявления ошибок в

документации равна

.

Вероятность невыявления ошибок в

документации равна

.

.

Искомая

дисперсия равна

.

.

Для

оценки рассеяния возможных значений случайной величины вокруг ее среднего

значения служит также среднее квадратическое отклонение.

Средним

квадратическим отклонением случайной величины Х называется квадратный корень из

дисперсии:

. (6.5)

. (6.5)

Пример

8. Cлучайная величина Х задана следующим законом распределения:

Таблица 6.8

|

2310 2310

|

|

|

|

|

0,10,40,5 0,10,40,5

|

|

|

|

Найти

среднее квадратическое отклонение  .

.

Решение. Математическое ожидание М(Х) равно:

.

.

Математическое

ожидание  равно:

равно:

.

.

Найдем

дисперсию:

.

.

Искомое среднее квадратическое отклонение равно:

.

.

Вопросы для повторения и контроля:

1. Что называется числовыми характеристиками случайной величины и

какие их виды вы знаете?

2. Что такое математическое ожидание и как оно определяется?

. Чему равно математическое ожидание числа появлений события в

одном испытании и как оно находится?

. Что вы знаете о 1- и 2-свойствах математического ожидания

(свойства 6.1 и 6.2)?

. Какие случайные величины называются независимыми и что является

произведением

независимых случайных величин?

. Как определяется сумма случайных величин?

7. Что вы знаете о 3- и 4-свойствах математического ожидания, а

также об их следствиях (свойства 6.3 и 6.4, следствия 6.1 и 6.2)?

. В чем целесообразность введения других числовых характеристик

случайной величины, кроме математического ожидания, и что такое отклонение

случайной величины?

. Что такое дисперсия и как она находится?

. Что вы знаете о 1- и 2-свойствах дисперсии (свойства 6.6 и

6.7)?

. Что вы знаете о 3-свойстве дисперсии и его следствиях (свойство

6.8, следствия 6.3 и 6.4)?

. Что вы знаете о 4-свойстве дисперсии (свойство 6.9)?

. Чему равны математическое ожидание и дисперсия числа появлений

события А в n независимых испытаниях (свойства 6.5 и 6.10)?

14. Что такое среднее квадратическое отклонение и как оно

определяется?

Опорные слова:

Числовые характеристики случайной величины, математическое ожидание, независимые

случайные величины, произведение независимых случайных величин, сумма случайных

величин, отклонение случайной величины, дисперсия, среднее квадратическое

отклонение.

. Функции распределения и плотности непрерывных случайных величин, их

свойства

Дискретная случайная величина может быть задана перечнем всех ее

возможных значений и их вероятностей. Однако такой способ задания неприменим

для непрерывных случайных величин.

Например,

рассмотрим случайную величину Х, возможные значения которой сплошь заполняют

интервал  . Очевидно, что невозможно составить перечень всех

возможных значений Х. Поэтому целесообразно дать общий способ задания любых

типов случайных величин, для чего вводятся функции распределения вероятностей

случайной величины.

. Очевидно, что невозможно составить перечень всех

возможных значений Х. Поэтому целесообразно дать общий способ задания любых

типов случайных величин, для чего вводятся функции распределения вероятностей

случайной величины.

Пусть

х - действительное число. Вероятность события, состоящего в том, что Х примет

значение, меньшее х, т.е. вероятность события  ,

обозначим через

,

обозначим через  . Если х изменяется, то изменяется и

. Если х изменяется, то изменяется и  , т.е.

, т.е.  -

функция от х.

-

функция от х.

Функцией

распределения случайной величины Х называется функция  , определяющая вероятность того, что случайная

величина Х в результате испытания примет значение, меньшее х, т.е.

, определяющая вероятность того, что случайная

величина Х в результате испытания примет значение, меньшее х, т.е.

. (7.1)

. (7.1)

Геометрически

это равенство можно истолковать так:  есть

вероятность того, что случайная величина примет значение, которое изображается

на числовой оси точкой, лежащей левее точки х.

есть

вероятность того, что случайная величина примет значение, которое изображается

на числовой оси точкой, лежащей левее точки х.

Теперь

рассмотрим свойства функции распределения.

Свойство

7.1. Значения функции распределения принадлежат отрезку  :

:

. (7.2)

. (7.2)

Доказательство.

Свойство вытекает из определения функции распределения как вероятности:

вероятность всегда есть неотрицательное число, не превышающее единицы.

Свойство

7.2.  - неубывающая функция, т.е.:

- неубывающая функция, т.е.:

, если

, если  . (7.3)

. (7.3)

Следствие

7.1. Вероятность того, что случайная величина примет значение, заключенное в

интервале  , равна приращению функции распределения на этом

интервале:

, равна приращению функции распределения на этом

интервале:

. (7.4)

. (7.4)

Пример

1. Cлучайная величина Х задана следующей функцией распределения:

.

.

Найти

вероятность того, что в результате испытания Х примет значение, принадлежащее

интервалу  :

:

.

.

Решение.

Так как на интервале  , по условию,

, по условию,

,

,

то

.

.

Итак,

.

.

Следствие

7.2. Вероятность того, что непрерывная случайная величина Х примет одно

определенное значение, равна нулю.

Свойство

7.3. Если возможные значения случайной величины принадлежат интервалу  , то: 1)

, то: 1)  при

при  ; 2)

; 2)  при

при  .

.

Доказательство.

1) Пусть  . Тогда событие

. Тогда событие  невозможно

(так как значений, меньших

невозможно

(так как значений, меньших  ,

величина Х по условию не принимает) и, следовательно, вероятность его равна

нулю.

,

величина Х по условию не принимает) и, следовательно, вероятность его равна

нулю.

)

Пусть  . Тогда событие

. Тогда событие  достоверно (так как все возможные значения Х меньше

достоверно (так как все возможные значения Х меньше  ) и, следовательно, вероятность его равна единице.

) и, следовательно, вероятность его равна единице.

Следствие

7.3. Если возможные значения непрерывной случайной величины расположены на всей

числовой оси х, то справедливы следующие предельные соотношения:

;

;  . (7.5)

. (7.5)

График

функции распределения непрерывной случайной величины в силу свойства 7.1

расположен в полосе, ограниченной прямыми  ,

,  .

.

Из

свойства 7.2 вытекает, что при возрастании х в интервале  , в котором заключены все возможные значения случайной

величины, график имеет вид либо наклона вверх, либо горизонтальный.

, в котором заключены все возможные значения случайной

величины, график имеет вид либо наклона вверх, либо горизонтальный.

В

силу свойства 7.3 при  ординаты графика равны нулю; при

ординаты графика равны нулю; при  ординаты графика равны единице.

ординаты графика равны единице.

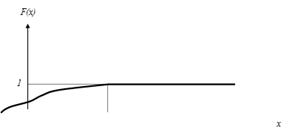

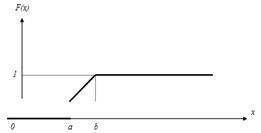

График

функции распределения непрерывной случайной величины изображен на рис. 7.1.

Рис.

7.1.

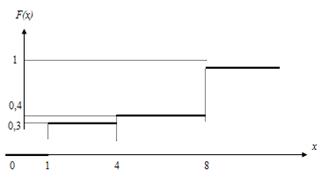

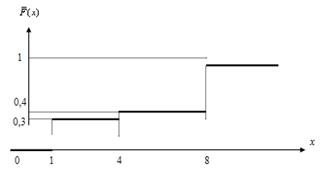

График

функции распределения дискретной случайной величины имеет ступенчатый вид.

Пример

2. Дискретная случайная величина Х задана следующим законом распределения:

Таблица 7.1

|

148 148

|

|

|

|

|

0,30,10,6 0,30,10,6

|

|

|

|

Найти функцию

распределения и вычертить ее график.

Решение.

Если  , то по свойству 7.3

, то по свойству 7.3  .

.

Если

, то

, то  .

Действительно, Х может принять значение 1 с вероятностью 0,3.

.

Действительно, Х может принять значение 1 с вероятностью 0,3.

Если

, то

, то  .

Действительно, если

.

Действительно, если  удовлетворяет неравенству

удовлетворяет неравенству  , то

, то  равно

вероятности события

равно

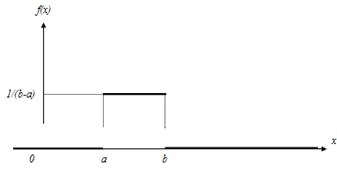

вероятности события  , которое может быть осуществлено, когда Х примет